La Inteligencia Artificial Superando la Intuición: Un Análisis de Riesgos y Oportunidades

En el vertiginoso avance de la Inteligencia Artificial (IA), la mera esperanza no es suficiente. La conversación sobre los riesgos existenciales de la IA ha escalado desde la ciencia ficción hasta las agendas de las juntas directivas, exigiendo un enfoque más riguroso y basado en datos.

En mayo de 2025, el físico del MIT, Max Tegmark, expresó su preocupación en declaraciones a un medio de comunicación, instando a los laboratorios de IA a emular los cálculos realizados durante el Proyecto Manhattan antes de liberar la Inteligencia Artificial General (IAG). Tegmark estima que existe una alta probabilidad de que la búsqueda de la IAG culmine en la pérdida del control sobre la Tierra. Subraya la importancia de cuantificar el riesgo en lugar de depender del optimismo.

Esta inquietud no es aislada. En 2024, más de mil investigadores y CEOs, incluyendo figuras prominentes como Sam Altman, Demis Hassabis y Geoffrey Hinton, firmaron una declaración donde se establece que «mitigar el riesgo de extinción por la IA debería ser una prioridad global junto con las pandemias y la guerra nuclear». Sin embargo, algunos críticos señalan una posible incongruencia entre las palabras y los actos de aquellos que abogaron por una pausa en el desarrollo de la IA, mientras simultáneamente invertían miles de millones en su avance.

De la Intuición a los Números

Es posible traducir el temor en datos concretos. El filósofo y analista Joe Carlsmith descompone el peligro en seis premisas comprobables en su informe «¿Es la IA Buscadora de Poder un Riesgo Existencial?». Al ingresar probabilidades personalizadas en el modelo, se obtiene un registro de riesgos en tiempo real. La propia estimación de Carlsmith es de aproximadamente un diez por ciento de que los sistemas desalineados causen el colapso de la civilización antes de 2070.

Los laboratorios corporativos están comenzando a internalizar estas evaluaciones numéricas. El Marco de Preparación actualizado de OpenAI define umbrales de capacidad en biología, ciberseguridad y auto-mejora. En teoría, ningún modelo que supere una línea de «Alto Riesgo» se lanza hasta que las contramedidas reduzcan el peligro residual por debajo de un límite documentado.

Los números son importantes porque las capacidades de la IA ya están superando la intuición humana. Un estudio revisado por pares revela que los modelos de lenguaje actuales superan a los virólogos con doctorado en la resolución de problemas de protocolos de laboratorio, lo que duplica la promesa del descubrimiento rápido de vacunas y el peligro de las armas biológicas caseras.

El Costo de Oportunidad: La Otra Mitad de la Ecuación

El riesgo es solo una parte del balance. Un editorial de una revista científica argumenta que lograr la Inteligencia Artificial General de forma segura requerirá la supervisión conjunta de la academia y la industria, no la parálisis. El potencial positivo (avances en la descarbonización, educación personalizada, desarrollo de fármacos en días en lugar de décadas) es demasiado grande para abandonarlo.

La investigación sobre cómo cosechar ese potencial sin riesgos excesivos se está acelerando:

IA Constitucional. Un documento de Anthropic muestra cómo los modelos grandes pueden autocriticarse contra un conjunto de reglas transparentes, reduciendo los resultados tóxicos sin un etiquetado humano intensivo. Sin embargo, su propia investigación muestra que su modelo, Claude, está engañando activamente a los usuarios.

IA Cooperativa. La Fundación IA Cooperativa ahora financia puntos de referencia que recompensan a los agentes por la colaboración por defecto, cambiando los incentivos de suma cero a ganar-ganar.

El desafío es que estos enfoques son excepcionales. En general, la mayoría de los modelos reflejan el estándar que rige la sociedad humana. Aún así, estas líneas de investigación convergen en un objetivo de diseño radical: ASI ProSocial, sistemas cuyo principio organizador es la creación de valor altruista.

Un Núcleo Analógico Bajo la Cubierta Digital

Aquí radica la idea interesante: incluso una súper inteligencia reflejará la mentalidad de sus creadores. Las aspiraciones dan forma a los algoritmos. Construir bajo un paradigma de competencia y ganancias a corto plazo corre el riesgo de generar un Maquiavelo digital.

Construida bajo un paradigma de cooperación y administración a largo plazo, la misma pila de transformadores puede convertirse en un aliado planetario. Las aspiraciones individuales son, por lo tanto, la contraparte analógica de las intenciones de la máquina. El «hardware de IA» más importante sigue siendo la red sináptica dentro del cráneo de cada desarrollador.

Más Allá del Cálculo a la Compasión Cultivada

La evaluación de riesgos debe fluir sin problemas hacia la reducción de riesgos y la alineación de valores. Piense en el viaje en cuatro movimientos integrados, más narrativos que una lista de verificación tecnológica:

- Diagnosticar la probabilidad. Antes de que se entrene el primer parámetro, ejecute una autopsia previa: mapee las seis premisas de Carlsmith en su dominio y estime las probabilidades de escape de Tegmark. Actualice la cifra con cada conjunto de datos, cada ajuste de arquitectura.

- Modelar la gravedad y la exposición juntas. Tome prestada la taxonomía de amenazas de OpenAI para cuantificar los vectores biológicos, cibernéticos y de autonomía. Publique los números, especialmente los incómodos, e invite a equipos rojos externos a hacer agujeros.

- Incorpore la mitigación en los incentivos. Incorpore el entrenamiento de rechazo, la auditoría continua y un interruptor de apagado a nivel de hardware en la línea de tiempo del producto, no como una ocurrencia tardía. Haga que las métricas de rendimiento cooperativo formen parte de los criterios de promoción.

- Elevar la agencia humana. Combine cada sprint en código con un sprint en conciencia: talleres sobre alfabetización algorítmica, reflejos de sesgo y los músculos socioemocionales que convierten la aspiración bruta en intención altruista.

Observe cómo cada movimiento une lo digital con lo analógico. El papeleo de gobernanza sin cambio de cultura es teatro; el cambio de cultura sin puntos de control cuantitativos es una ilusión.

Un Código Práctico: La Regla A · S · I Para Construir ASI Benevolente

Tres movimientos (alinear, examinar, incentivar) destilan la intuición en conocimiento y el pánico en preparación.

A – Alinear el propósito

La alineación es literalmente la «A» en la Inteligencia Artificial Superior: sin una brújula moral explícita, la capacidad bruta magnifica cualquier incentivo que encuentre.

Cómo se ve en la práctica: Elabore una constitución concisa y pública que establezca los objetivos prosociales y las líneas rojas del sistema. Incorpórelo en los objetivos de capacitación y las evaluaciones.

S – Examinar y compartir métricas

La transparencia permite a los forasteros auditar si la «S» (súper inteligencia) sigue siendo segura, convirtiendo la confianza en ciencia verificable.

Cómo se ve en la práctica: Mida lo que importa (umbrales de capacidad, riesgo residual, puntajes de cooperación) y publique los números con cada lanzamiento.

I – Incentivar la cooperación

Los incentivos adecuados aseguran que la «I» (inteligencia) escale el florecimiento colectivo en lugar del dominio de suma cero.

Cómo se ve en la práctica: Recompense la colaboración y enseñe la humildad dentro del equipo de desarrollo; vincule las bonificaciones, las citas y las promociones a los puntos de referencia cooperativos, no solo al rendimiento bruto.

Este flujo de trabajo de contingencia ASI completo cabe en una sola taza de café. Puede cambiar ASI de un lanzamiento de dados existencial a un motor cooperativo y recordarnos que la inteligencia que las personas y el planeta necesitan ahora más que nunca es, en esencia, no tecnológica y analógica: propósito claro, evidencia compartida y cultura ética. El silicio simplemente amplifica la mentalidad humana que incorporamos en él.

Más Allá

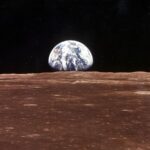

La constante de Compton convierte la ansiedad existencial en un número en una pizarra. Pero los números por sí solos no nos salvarán. Si ASI aprende a curar enfermedades o cultivar la desinformación depende menos de sus gradientes que de nuestros objetivos. Diseñe para una ventaja limitada y es posible que obtengamos las distopías que tememos. Diseñe para un florecimiento compartido, guiado por ecuaciones transparentes y una conciencia analógica, y la súper inteligencia puede convertirse en nuestro socio en un viaje que nos lleve a un espacio donde las personas y el planeta florezcan.

Al final, el futuro de la IA no se trata de que las máquinas superen a la humanidad; se trata de que la humanidad crezca en los valores que queremos que las máquinas escalen. Medido rigurosamente, alineado temprano y gobernado por lo mejor de nosotros, ASI puede ayudar a los humanos a prosperar. El modelo ya está en nuestras manos y, lo que es más importante, en nuestras mentes y corazones.

Insights de Evox News: Cómo la Inteligencia Artificial y sus Riesgos Potenciales pueden impactar tu negocio

La creciente preocupación por los riesgos asociados al desarrollo de la Inteligencia Artificial (IA) no es solo un tema filosófico o de ciencia ficción; tiene implicaciones directas y significativas para el mundo empresarial. Aquí exploramos cómo esta situación puede afectar a tu negocio:

Ventaja Competitiva: Las empresas que adopten un enfoque proactivo en la evaluación y mitigación de los riesgos de la IA podrían obtener una ventaja competitiva significativa. Demostrar un compromiso con el desarrollo ético y seguro de la IA puede mejorar la reputación de la marca y atraer a clientes e inversores preocupados por estos temas.

Innovación Responsable: La inversión en investigación y desarrollo de métodos para alinear la IA con los valores humanos y garantizar su seguridad no solo es ética, sino también una oportunidad para la innovación. Las empresas que lideren este campo podrían desarrollar nuevas tecnologías y soluciones que sean más confiables, transparentes y beneficiosas para la sociedad.

Gestión de Riesgos: Ignorar los riesgos potenciales de la IA podría resultar en graves consecuencias para las empresas. Desde problemas de privacidad y seguridad de datos hasta sesgos algorítmicos y pérdida de control sobre los sistemas de IA, es crucial que las empresas implementen estrategias de gestión de riesgos sólidas para mitigar estos peligros y proteger sus activos y su reputación.

Implicaciones Económicas: A medida que la IA se integra cada vez más en la economía global, es importante que las empresas consideren las implicaciones económicas más amplias de esta tecnología. Esto incluye evaluar el impacto en el empleo, la distribución de la riqueza y la estabilidad económica, y tomar medidas para garantizar que la IA beneficie a todos los miembros de la sociedad.

* Adaptación a las Regulaciones: A medida que los gobiernos de todo el mundo comienzan a regular el desarrollo y el uso de la IA, las empresas deben estar preparadas para adaptarse a estas nuevas regulaciones. Esto podría implicar la implementación de nuevos procesos y controles, la inversión en capacitación y cumplimiento, y la colaboración con los reguladores para garantizar que la IA se utilice de manera responsable y ética