EuroEFE Explica: La Ley de Inteligencia Artificial

Por Lucía Leal

Madrid (EuroEFE).- La normativa pionera a nivel mundial sobre inteligencia artificial es ya una realidad. Con su implementación, los países de la Unión Europea (UE) comenzarán en los próximos meses a restringir ciertos sistemas, basándose en el nivel de riesgo que estos representen para los ciudadanos.

A continuación, detallamos lo que esto implica para usted:

¿Cuál es su origen?

La creciente inquietud por el veloz avance de la inteligencia artificial (IA) motivó a la Comisión Europea a presentar esta ley en abril de 2021. La iniciativa legislativa se alimentó de diversas sugerencias de la ciudadanía recogidas durante la Conferencia sobre el Futuro de Europa, así como del deseo de fortalecer a la industria europea en competencia con China y Estados Unidos.

El proyecto original no contemplaba los sistemas generativos. Sin embargo, la irrupción el año pasado de programas como ChatGPT impulsó a los Veintisiete a incorporarlos en la legislación. Aunque inicialmente Francia, Alemania e Italia mostraron reticencias a regularlos para no limitar el potencial de empresas como la francesa Mistral AI o la alemana Aleph Alpha, finalmente accedieron a hacerlo.

¿Cómo le concierne?

- Se podrá seguir utilizando sistemas generativos ampliamente conocidos como ChatGPT, de Open AI, o Gemini (anteriormente Bard), de Google. No obstante, estos deberán cumplir con los derechos de autor y mantener la transparencia al producir textos o creaciones artísticas mediante inteligencia artificial.

- No se permitirá la vigilancia masiva por parte del Gobierno o de empresas privadas, ni tampoco sistemas de puntuación o manipulación social. Las empresas no podrán utilizar la IA para procesos de contratación, despido o evaluación laboral en la mayoría de los casos, ni las universidades para la selección de alumnos, ni los bancos para el análisis de solvencia.

- Se podrán interponer reclamaciones si se considera que un sistema vulnera los derechos de un individuo. Será ilegal el uso de ‘deepfakes’ engañosos o la interacción con un chatbot sin que se revele la ausencia de una persona real al otro lado.

- Si ha desarrollado u opera un sistema de inteligencia artificial en su empresa o entidad, puede verificar en este sitio web si está sujeto a las obligaciones establecidas por la nueva ley.

¿En qué se fundamenta?

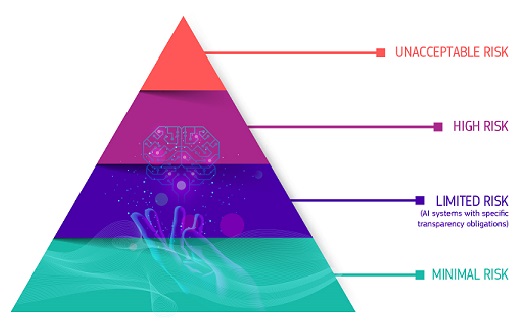

♦ El documento aprobado por el Parlamento Europeo en marzo clasifica los riesgos asociados a la inteligencia artificial en cuatro niveles:

- «Riesgo Inaceptable»: Los sistemas que entren en esta categoría quedan prohibidos en la UE por infringir derechos o valores fundamentales de la unión.

Ejemplos: Se prohíben aquellos que utilicen mecanismos de reconocimiento facial, de voz u otros similares en espacios públicos en tiempo real; los destinados a otorgar una puntuación social a los ciudadanos, como los existentes en China; los que empleen técnicas subliminales o manipuladoras; aquellos que puedan causar perjuicio a grupos vulnerables específicos, como personas con discapacidad o menores; o los sistemas de clasificación biométrica que infieran la raza, las inclinaciones políticas o la orientación sexual de un individuo, así como los que detecten sus emociones en el entorno laboral. Esta lista podrá ser actualizada periódicamente.

Excepciones: Las autoridades policiales podrán utilizar cámaras de reconocimiento facial y otros sistemas de vigilancia biométrica en tiempo real, bajo autorización judicial previa, en situaciones de amenazas terroristas inminentes, búsqueda de menores desaparecidos o secuestrados, o persecución de autores de delitos graves. La ley tampoco se aplica, en términos generales, a sistemas con fines de investigación científica, defensa o seguridad nacional.

- «Alto riesgo» para la seguridad, salud, derechos humanos, democracia o medio ambiente: Los responsables de estos sistemas deberán someterse a una evaluación para acreditar que cumplen con la normativa. Ejemplos:

- Sistemas utilizados por las autoridades para la detección de ultrafalsos o ‘deepfakes’ (vídeos manipulados que simulan ser reales y pueden atribuir a una persona declaraciones o acciones falsas).

- Aquellos empleados en procesos de selección de personal o admisión universitaria, así como para la promoción o despido de empleados.

- Los utilizados por entidades financieras para evaluar la solvencia y la calificación crediticia de los clientes; aquellos que puedan tener influencia en elecciones o votaciones.

- Los empleados para el funcionamiento de infraestructuras críticas.

- Los utilizados por autoridades policiales, judiciales o migratorias para el análisis de pruebas de delitos y solicitudes de visado o asilo.

- «Riesgo de transparencia»: Sus responsables deben cumplir con requisitos que eviten el engaño a los consumidores, haciéndoles creer que interactúan con personas o contenidos reales.

Ejemplos: Los propietarios de chatbots o creadores de ‘deepfakes’, quienes deberán informar a los usuarios de su naturaleza (excepto cuando se utilicen para la prevención de delitos); o las empresas que empleen sistemas de IA en el ámbito laboral, que deberán notificarlo a sus empleados y a los sindicatos.

- «Riesgo mínimo»: Los filtros de spam y otros sistemas que no representen amenazas significativas para las personas solo deberán cumplir con las regulaciones generales de la UE, como la ley de protección de datos o la de derechos de autor.